- Mark Ren

-

-

-

在人工智能领域,技术进化的速度总是超乎想象。就在大家还在惊叹 GPT-4、PaLM 等大模型的强大之时,一位“新晋玩家”横空出世,带着尖端技术和实际成果,成功吸引了全球的目光。这就是 DeepSeek,一家来自中国的 AI 初创公司,以出色的技术架构、卓越的模型性能,以及从高性能到轻量化的多元应用场景,让人们看到了大模型发展的新可能。

如果把人工智能的生态比作一个江湖,DeepSeek 就像一个初入江湖的青年,却凭借硬实力和灵活策略,在高手如云的领域中脱颖而出。那么,DeepSeek 的技术究竟有何过人之处?又是如何在全球竞争中赢得自己的一席之地的?本文将带你深入解析 DeepSeek 的技术架构、核心模型以及其版本间的差异。

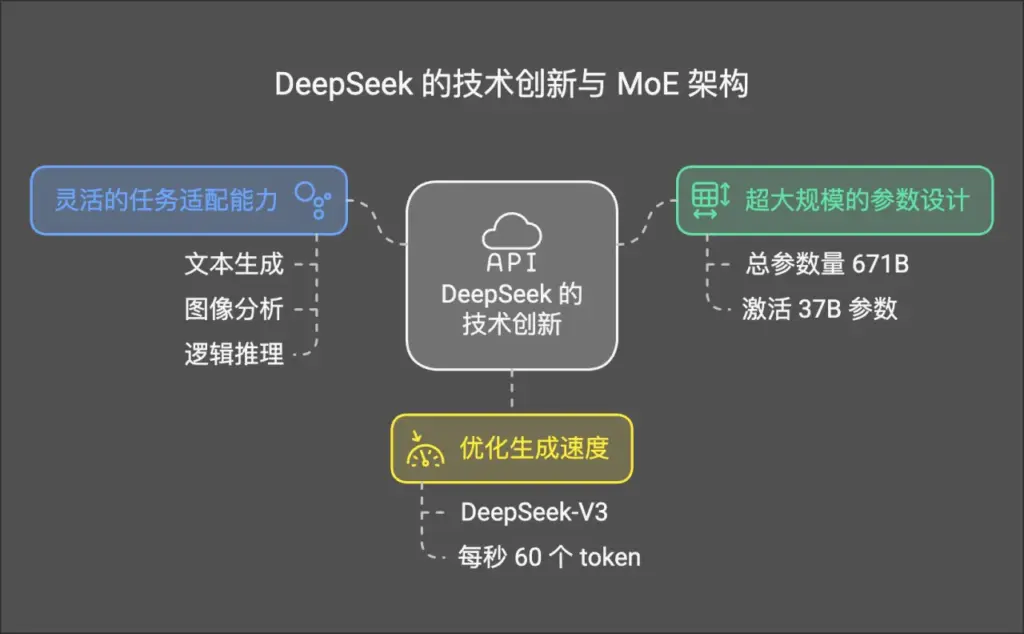

从 MoE 架构看 DeepSeek 的技术创新

DeepSeek 的技术根基在于其采用的 混合专家(Mixture-of-Experts, MoE) 架构。与传统的大模型架构不同,MoE 架构通过稀疏激活技术,在保持强大推理能力的同时,大幅降低了计算资源的消耗。

什么是 MoE?为什么它如此强大?

你可以把 MoE 想象成一个拥有众多专家的团队,每位专家都有自己的专长(比如擅长分析文本、处理图片、理解数学公式等)。在面对具体问题时,模型只需要调动相关的几位专家,而不是让所有专家一起工作。这种方式让计算变得更加高效,也大大提升了模型在复杂任务中的灵活性。

DeepSeek 如何用好 MoE?

- 超大规模的参数设计:

- DeepSeek 的模型,比如 DeepSeek-V3 和 R1,总参数量高达 671B(6710 亿)。但每次推理只激活 37B 参数。

- 这种设计让模型在面对复杂任务时依然能保持高性能,而无需消耗不必要的计算资源。

- 灵活的任务适配能力:

- MoE 的架构使 DeepSeek 能够针对不同场景调用特定的“专家层”,比如文本生成、图像分析、逻辑推理等。无论任务多么复杂,DeepSeek 都能“对症下药”,提供精准的解决方案。

- 优化生成速度:

- DeepSeek 在 MoE 架构的基础上加入了工程优化,使得模型的生成速度大幅提升。以 DeepSeek-V3 为例,它每秒生成 60 个 token,是上一代模型速度的 3 倍。

DeepSeek 数据流处理图

展示从输入数据到结果生成的完整流程,可以细化 MoE 架构的实际作用:

flowchart TD A[输入数据 文本/图像] --> B[数据预处理] B --> C[任务特征提取] C --> D[专家层选择-MoE] D --> E[专家层推理] E --> F[结果整合] F --> G[输出任务结果] subgraph 优化机制 C --> H[动态专家激活] H --> D F --> I[反馈学习] I --> D end

DeepThink-R1是更贴切的叫法:用Think而不只是Seek

在 DeepSeek 的模型系列中,R1 是当之无愧的“领军人物”。它不仅在技术架构上延续了 MoE 的精髓,还通过独特的训练方式和顶尖的推理性能,展现了行业标杆级别的表现。

DeepSeek 强化学习机制流程图

详细说明 DeepSeek-R1 的强化学习过程,用来突出它在试错学习和动态调整方面的能力:

flowchart LR A[初始模型训练] --> B[试错任务生成] B --> C[推理结果评估] C --> D[奖励或惩罚反馈] D --> E[模型参数调整] E --> F[强化学习迭代] F --> C F --> G[优化后模型]

1. 独特的训练方式:强化学习驱动

传统大模型的训练大多依赖于标注数据,也就是我们所熟悉的“监督微调(SFT)”。然而,DeepSeek-R1 另辟蹊径,采用了强化学习(Reinforcement Learning, RL)作为核心训练方法,尤其是其 R1-Zero 版本,完全不依赖任何标注数据。

这种方法的优势在于:

- 自适应能力强:

模型通过试错机制学会解决问题,特别是在逻辑推理和复杂任务中,R1 的动态学习能力显得尤为突出。 - 减少标注成本:

对比传统方法,强化学习显著降低了对高质量标注数据的需求,让训练变得更加高效。

举个例子:在数学推理任务中,R1 并不是单纯依靠死记硬背公式,而是能根据题目背景和已知条件,动态生成合理的解题路径。这种能力让它在逻辑性要求高的任务中独树一帜。

2. 超强推理性能:复杂场景的全能选手

DeepSeek-R1 的强大不仅体现在训练方式上,更在于它的推理能力。在多个基准测试中,R1 的表现令人惊艳:

- 数学与逻辑测试:

R1 的表现超越了大多数开源模型,甚至在一些领域击败了商业闭源模型。这种表现让它成为科研计算、智能决策支持等领域的理想选择。 - 多模态处理:

除了文本和逻辑推理,R1 在图像处理等多模态任务中也有不俗的表现,展现了通用大模型的全面实力。

3. 开源的价值:推动技术普惠

DeepSeek-R1 不仅是一款高性能的商业模型,它还展现了 DeepSeek 在推动开源技术发展上的决心:

- R1 的多个版本(包括蒸馏模型,参数规模从 1.5B 到 70B)已完全开源。

- 通过开源,DeepSeek 希望降低技术门槛,让更多开发者能够接触并使用顶尖的大模型技术。

这种开源策略不仅加强了 DeepSeek 在开发者社区的影响力,也为全球 AI 技术生态注入了新的活力。

DeepSeek 家族其他版本:一场针对多样化场景的技术盛宴

如果说 R1 是“全能高手”,那么 DeepSeek 的其他版本则各有侧重,分别针对特定需求进行优化。这种“家族化策略”展现了 DeepSeek 对市场和技术应用场景的精准把握。

DeepSeek-V3:性能与多模态的完美平衡

V3 是一款通用型大模型,既能在多模态任务中表现出色,又能胜任高效的文本生成任务。它的多面性让它成为智能助手、内容创作等领域的热门选择。

- 参数规模: 总参数 671B,每次激活 37B。

- 多模态优化: 特别针对文本与图像的融合处理,支持从描述生成图片到多模态分析的复杂任务。

- 高速生成: V3 的生成速度达到每秒 60 个 token,大幅提升了应用效率。

DeepSeek-V2:为长文本生成而生

V2 的亮点在于对长上下文处理的支持,适合需要上下文记忆和大规模知识处理的任务场景。

- 上下文长度: 支持最长 128K token,是长文档生成的不二之选。

- 轻量化设计: 通过每次激活 21B 参数的方式,显著降低推理成本。

- 应用场景: 从学术论文生成到长篇报告撰写,V2 在文本生成任务中游刃有余。

DeepSeek-V2-Lite:边缘计算的轻量化解决方案

在物联网、智能家居等资源受限的场景下,DeepSeek-V2-Lite 以轻量化设计赢得了用户的青睐。

- 参数规模: 总参数仅 16B,每次激活 2.4B。

- 高性价比: 适合部署在边缘计算设备上,为资源有限的场景提供优质 AI 服务。

以下是完整 Blog 的后半部分内容(约 1500 字):

DeepSeek 家族的版本对比与技术差异

在 DeepSeek 系列中,多个版本的设计各有侧重,针对不同的应用场景提供了灵活且高效的解决方案。那么,这些版本之间究竟有何技术差异?通过对比,我们可以更清晰地了解它们的适用场景和技术亮点。

1. DeepSeek-R1 vs DeepSeek-V3

| 特性 | DeepSeek-R1 | DeepSeek-V3 |

|---|---|---|

| 核心架构 | MoE(671B 总参数,激活 37B) | MoE(671B 总参数,激活 37B) |

| 主要优化方向 | 强化学习驱动推理、逻辑推理性能卓越 | 通用任务性能、多模态处理能力 |

| 主要场景 | 高性能推理、科研计算、智能决策支持 | 智能助手、内容创作、多模态分析 |

| 生成速度 | 标准高速 | 每秒生成 60 token,优化显著 |

| 开放性 | 支持开源,提供蒸馏版本 | 未全面开源,更多商业用途 |

graph LR subgraph DeepSeek 家族对比 A[DeepSeek-R1] --> |高性能推理| B[科研计算] A --> |动态推理| C[逻辑分析] D[DeepSeek-V3] --> |多模态支持| E[智能助手] D --> |快速生成| F[内容创作] G[DeepSeek-V2] --> |长上下文| H[知识管理] G --> |长文本生成| I[报告撰写] J[DeepSeek-V2-Lite] --> |轻量化模型| K[物联网] J --> |边缘计算| L[智能家居] end

解读:

DeepSeek-R1 强调逻辑性强的任务,比如数学推理和复杂决策支持,它的强化学习训练方法让其在动态场景中表现突出。而 DeepSeek-V3 则更倾向于通用应用,尤其是在需要多模态处理(如图片与文字结合)的场景中展现出了全面性和高效性。

2. DeepSeek-V2 vs DeepSeek-V2-Lite

| 特性 | DeepSeek-V2 | DeepSeek-V2-Lite |

|---|---|---|

| 核心架构 | MoE(236B 总参数,激活 21B) | MoE(16B 总参数,激活 2.4B) |

| 上下文长度支持 | 最长 128K Token | 标准上下文长度 |

| 主要优化方向 | 长文本生成、上下文记忆 | 轻量化设计、边缘计算支持 |

| 计算需求 | 中等 | 低 |

| 应用场景 | 学术论文生成、大规模知识管理 | 智能家居、物联网边缘设备 |

解读:

DeepSeek-V2 的设计更适合需要处理长文本和复杂上下文的任务,比如长篇报告生成或知识图谱扩展。而 V2-Lite 则是边缘计算场景的最佳选择,其轻量化架构不仅降低了计算需求,还适合在资源有限的设备上运行,比如智能家居和工业 IoT 节点。

综合对比:模型选择指南

为了帮助你快速选择最适合的模型,以下是一个简要的模型推荐表:

| 需求类型 | 推荐版本 | 理由 |

|---|---|---|

| 高性能推理、科研计算 | DeepSeek-R1 | 强化学习驱动逻辑推理,动态能力强 |

| 智能助手、多模态任务处理 | DeepSeek-V3 | 通用性强,支持多模态数据处理 |

| 长文本生成、知识图谱扩展 | DeepSeek-V2 | 支持 128K 上下文,长序列任务的最佳选择 |

| 资源受限的边缘计算场景 | DeepSeek-V2-Lite | 轻量化设计,适配物联网和智能家居 |

flowchart TD A[输入任务] --> B[数据预处理] B --> C[混合专家选择] C --> D[激活相关专家层] D --> E[推理过程] E --> F[结果生成] F --> G[反馈优化] subgraph 强化学习支持R1 G --> H[试错学习机制] H --> C end subgraph 标准推理V3&V2 G --> I[固定优化路径] I --> C end

DeepSeek 的潜力

DeepSeek 在技术上的突破令人瞩目,但更值得探讨的是它对行业发展的影响和未来潜力。以下是几个关键方向:

1. 技术创新的引领者

DeepSeek 的 MoE 架构不仅提升了大模型的效率,还为行业树立了如何在性能和资源之间找到平衡的标杆。随着未来硬件技术的进步,DeepSeek 很可能会进一步优化其架构,比如:

- 动态专家激活: 进一步提升对任务类型的精准匹配。

- 分布式推理: 通过云边协同优化,降低模型的集中计算压力。

2. 开源生态的推动者

DeepSeek 在开源实践上的大胆尝试,让更多开发者能够使用顶尖的 AI 技术。通过提供蒸馏版本和轻量化模型,DeepSeek 正在降低技术门槛,让 AI 技术的普惠成为可能。

展望: 未来,DeepSeek 的开源生态或许不仅局限于提供模型,还可能扩展到工具链和框架层面,为开发者提供从训练到部署的全套解决方案。

3. 多样化场景的开拓者

无论是高性能计算、智能助手,还是轻量化边缘应用,DeepSeek 的多版本策略都展示了其覆盖多样化场景的能力。在未来,这种策略可能会继续延伸:

- 行业定制模型: 针对医疗、教育、金融等行业开发专属模型,满足垂直领域的需求。

- 边缘设备优化: 在 IoT 和工业设备领域,进一步提升轻量化模型的适配能力。

结语:DeepSeek 的独特魅力

DeepSeek 不仅是一个技术领先的 AI 公司,更是行业中一个勇于探索和创新的玩家。它通过混合专家架构、强化学习训练和开源实践,为大模型的发展提供了新的可能性。

无论你是 AI 技术的研究者,还是行业中的实际应用者,DeepSeek 的模型都值得一试。通过 R1 的顶级性能,V3 的全面能力,以及 V2 系列的灵活设计,DeepSeek 为不同行业和场景提供了从云到边的完整解决方案。

典型应用介绍