- Mark Ren

-

-

-

当语音芯片不再是唯一选择,通用 MCU 如何开启本地 AI 感知时代

一、为什么需要在 MCU 上跑 AI?

1. 语音唤醒早已普及,但创新停滞

从智能音箱到扫地机器人,从手表到家电遥控器,

“语音唤醒”早已不再是高端功能,而是每一款智能设备的基础能力。

这些系统大多依赖专用语音芯片,例如 ASR5505、BD3751、XMOS XVF 系列 等。

这类芯片封装成熟、功耗极低,内置语音引擎可直接识别固定关键词,

开发者只需配置触发命令即可完成语音控制。

然而,这类方案的封闭性也越来越明显:

- 关键词往往是固定的,不能动态修改;

- 固件和模型由厂商维护,缺乏灵活性;

- 语音算法版本不可更新,也无法支持个性化唤醒词。

在这个语音交互早已普及的时代,

创新的限制反而成了硬件层面最大的瓶颈。

2. MCU + AI 框架的兴起

随着芯片架构与神经网络框架的演进,一种新的思路逐渐成为趋势:

让通用 MCU 直接运行轻量化的 AI 模型,在本地实现推理与决策。

这一趋势的代表组合便是 ESP32-S3 + TensorFlow Lite Micro(简称 TFLM)。

- ESP32-S3 拥有 Wi-Fi + BLE 双模通信能力和 AI 指令集;

- TensorFlow Lite Micro 是专为资源受限设备设计的超轻量推理框架;

- 二者结合,可在几百 KB 的内存中实现本地语音唤醒、手势识别、声音分类等智能任务。

这种方案让“AI 不再依赖云端”,

设备可以在断网、低功耗的环境下独立完成感知与响应。

3. 本文目标

本文并非简单展示一个“语音唤醒示例”,

而是希望帮助开发者理解:

- TensorFlow Lite Micro 的意义远不止唤醒;

- ESP32-S3 让 AI 真正进入了 MCU 级别的计算空间;

- 通用 MCU + 模型部署的架构,正在成为低功耗智能设备的新主流。

接下来,我们将从技术原理、实现路径、应用拓展和系统演进四个层面,

全面拆解这一组合的潜力与实践。

二、技术原理:从“语音唤醒”到“边缘感知”

1. ESP32-S3 的硬件特性

ESP32-S3 是乐鑫推出的新一代物联网主控芯片,

相较于前代 ESP32,它在算力、AI 加速、低功耗和外设扩展方面都有显著提升。

| 模块 | 说明 |

|---|---|

| CPU | Xtensa LX7 双核,最高主频 240 MHz |

| AI / DSP 加速 | 支持向量指令集(SIMD),加速卷积与矩阵运算 |

| 内存 | 512 KB SRAM,可扩展外部 PSRAM |

| 无线通信 | Wi-Fi 2.4 GHz + BLE 5.0 |

| 接口 | I2S、SPI、UART、ADC、PWM 等 |

| 典型应用 | 离线语音识别、动作检测、环境声分析、机械振动监测 |

ESP32-S3 的 AI 指令集 能够在硬件层面优化矩阵乘法与卷积操作,

使其在执行小型神经网络(如 CNN、LSTM)时具备远超传统 MCU 的效率。

这意味着,开发者不再需要额外的 AI 协处理器或语音芯片,

仅凭一颗 ESP32-S3,就能让设备具备“听懂”或“感知”的能力。

2. TensorFlow Lite Micro 是什么

TensorFlow Lite Micro(TFLM) 是 TensorFlow 团队为 MCU、DSP 等嵌入式环境设计的轻量级推理框架。

它的核心理念是:

在没有操作系统、没有动态内存分配的微控制器上,也能运行深度学习模型。

TFLM 通过 静态内存分配 与 算子注册机制,

在极低资源下完成模型加载与推理过程。

| 特性 | 说明 |

|---|---|

| 体积小 | 典型运行库 < 100 KB |

| 无依赖 | 不依赖 RTOS、malloc 或文件系统 |

| 快速移植 | 支持 ARM、RISC-V、Xtensa 等架构 |

| 支持量化模型 | 可运行 int8 / uint8 神经网络 |

| 可扩展算子 | 支持自定义运算和轻量优化 |

这种“极简框架”思路非常契合 ESP32-S3 的系统结构,

在有限内存中实现 AI 能力,而不需要牺牲实时性或功耗。

3. 系统工作流程

当 TFLM 部署在 ESP32-S3 上时,

完整的语音识别或声音分类流程如下:

--- title: "ESP32-S3 + TensorFlow Lite Micro 工作流程" --- graph LR %% ===== 样式定义 ===== classDef input fill:#DCE8FF,stroke:#1A5FFF,stroke-width:2,rx:10,ry:10,color:#0B2161,font-weight:bold; classDef feature fill:#E1F5FE,stroke:#0288D1,stroke-width:2,rx:10,ry:10,color:#01579B,font-weight:bold; classDef model fill:#E8F5E9,stroke:#0A7E07,stroke-width:2,rx:10,ry:10,color:#064C00,font-weight:bold; classDef infer fill:#FFF8E1,stroke:#F57F17,stroke-width:2,rx:10,ry:10,color:#4E342E,font-weight:bold; classDef output fill:#F3E5F5,stroke:#6A1B9A,stroke-width:2,rx:10,ry:10,color:#311B92,font-weight:bold; %% ===== 节点定义 ===== A["🎤 音频输入<br/>(I2S 麦克风)"]:::input B["🎛 特征提取<br/>(MFCC / Mel 频谱)"]:::feature C["🧠 模型加载<br/>(TFLite Micro 模型)"]:::model D["⚙️ 推理执行<br/>(TensorFlow Lite Micro)"]:::infer E["📊 输出置信度结果"]:::output F["🚀 触发动作 / 本地事件上报"]:::output %% ===== 流程连接 ===== A --> B --> C --> D --> E --> F %% ===== 链接线条设置 ===== linkStyle default stroke:#555,stroke-width:1.8;

这一流程的意义在于,

开发者无需依赖厂商的语音算法库,

即可直接在 MCU 上构建属于自己的“听觉模型”。

例如:

- 在家庭设备中实现自定义唤醒词;

- 在工业设备中识别机械噪声模式;

- 在可穿戴设备中通过声音判断环境变化。

4. 为什么这种架构具备“可持续性”

传统语音芯片的算法是固化的,

而 MCU + TFLM 的方案是可演化的:

- 模型可以重新训练,随时替换;

- 不同场景可加载不同模型;

- 云端训练、本地推理形成闭环。

这不仅让设备更灵活,也让产品在出厂后仍能持续升级。

三、实现路径:在 ESP32-S3 上构建本地语音唤醒

让一颗 MCU 实现语音唤醒的完整过程,可以分为五个核心阶段:

- 音频采集与预处理

- 特征提取(MFCC)

- 模型设计与量化

- 模型部署与推理

- 性能评估与功耗控制

1. 音频输入与前端处理

(1)硬件接入

ESP32-S3 原生支持 I2S 数字音频接口,能够直接连接常见的 MEMS 麦克风,如 INMP441、SPH0645、MSM261S4030 等。

其数字接口避免了模拟噪声干扰,非常适合在小型设备中采集语音。

推荐配置:

| 参数 | 推荐值 | 说明 |

|---|---|---|

| 采样率 | 16 kHz | 保留人声主频段 |

| 量化位深 | 16 bit | 平衡精度与带宽 |

| 声道 | 单声道 | 语音识别无需立体声 |

| 帧长 | 40 ms(640 点) | 适配 MFCC 特征输入节奏 |

ESP-IDF 提供了完整的 I2S 驱动接口,能实现 DMA 流式采样与缓冲。

典型代码如下:

i2s_config_t i2s_config = {

.mode = I2S_MODE_MASTER | I2S_MODE_RX,

.sample_rate = 16000,

.bits_per_sample = I2S_BITS_PER_SAMPLE_16BIT,

.channel_format = I2S_CHANNEL_FMT_ONLY_LEFT,

.communication_format = I2S_COMM_FORMAT_I2S,

.dma_buf_count = 4,

.dma_buf_len = 256,

};(2)信号预处理

在原始语音进入模型之前,需要进行基础滤波与窗口化处理:

- 高通滤波:消除直流偏置;

- 预加重:突出高频特征;

- 分帧 + 加窗(Hamming):增强时间连续性;

- 静音检测 (VAD):降低无声段推理频率。

ESP-DSP 库提供了 esp_dsp_preemphasis_f32()、esp_dsp_hamming_window_f32() 等接口,

可直接在 MCU 端完成这些步骤,无需额外 DSP 芯片。

2. 特征提取:MFCC

(1)为什么选择 MFCC

MFCC(Mel-Frequency Cepstral Coefficients)是语音识别中最常用的特征。

它将波形信号转换为反映人耳感知的特征矩阵,

能显著减少模型的输入维度,并在低算力环境下保持识别精度。

(2)计算流程

- FFT:计算每帧语音的频谱能量;

- Mel 滤波器组:将频谱投射到 Mel 频率尺度;

- 取对数:模拟人耳的非线性听觉响应;

- DCT 变换:提取低维倒谱系数(一般取前 10~13 维)。

ESP32-S3 的 DSP 指令集可显著加速 FFT 与 DCT 运算,

在 16kHz 采样率下每帧 MFCC 处理仅需 2–3 ms。

3. 模型结构与量化

(1)模型设计

TensorFlow Lite Micro 运行的模型通常采用轻量化 CNN 架构:

| 层类型 | 功能 | 输出形状示例 |

|---|---|---|

| Conv2D + ReLU | 提取时间–频率特征 | 20×10×16 |

| DepthwiseConv2D | 降维、强化局部特征 | 10×5×32 |

| Flatten | 展平为向量 | 1600 |

| Dense + Softmax | 输出分类概率 | 2(yes/no) |

这种结构可在 100–300 KB 的模型规模下获得较高识别率。

(2)模型训练

可直接使用 TensorFlow 官方的 Speech Commands Dataset:

在 PC 或云端训练自定义关键词,如 “Hey Lamp”、“Hello Board”。

(3)模型量化

为适配 MCU 资源,需将模型从 float32 压缩为 int8:

converter = tf.lite.TFLiteConverter.from_saved_model("model_path")

converter.optimizations = [tf.lite.Optimize.DEFAULT]

converter.target_spec.supported_types = [tf.int8]

tflite_quant_model = converter.convert()量化后模型体积缩小约 4 倍,

精度损失通常低于 2%。

4. 模型部署与推理

(1)模型嵌入

TensorFlow Lite Micro 通过 C 数组模型加载:

xxd -i model.tflite > model_data.cc生成的文件类似:

const unsigned char model_data[] = {0x20,0x00,0x00,...};

const int model_data_len = 123456;(2)推理代码示例

#include "tensorflow/lite/micro/all_ops_resolver.h"

#include "tensorflow/lite/micro/micro_interpreter.h"

#include "model_data.h"

#define TENSOR_ARENA_SIZE (80 * 1024)

static uint8_t tensor_arena[TENSOR_ARENA_SIZE];

void app_main(void) {

const tflite::Model* model = tflite::GetModel(model_data);

static tflite::AllOpsResolver resolver;

static tflite::MicroInterpreter interpreter(model, resolver,

tensor_arena, TENSOR_ARENA_SIZE);

interpreter.AllocateTensors();

TfLiteTensor* input = interpreter.input(0);

while (true) {

GetAudioFeature(input->data.int8); // 填充 MFCC 输入

interpreter.Invoke(); // 执行推理

TfLiteTensor* output = interpreter.output(0);

if (output->data.uint8[0] > 200) {

printf("Wake word detected!\n");

}

}

}此代码展示了一个完整的嵌入式推理循环,

在 240MHz 主频下,可实现 15–20 FPS 的实时语音检测性能。

5. 性能指标与功耗

| 指标 | 结果 | 说明 |

|---|---|---|

| 推理延迟 | 50–60 ms | 每帧完整识别耗时 |

| 模型大小 | 约 240 KB | int8 量化后 |

| 内存占用 | 350 KB 左右 | 含缓冲区与张量 |

| CPU 占用率 | 50–60% | 单核负载 |

| 功耗 | 120 mA(运行时) / <10 mA(待机) | 适合电池设备 |

若开启低功耗监听模式(周期性采样 + 事件唤醒),

整机平均功耗可降至 30–40 mA,

支持长时运行与持续监听。

6. 开发过程中的调优要点

- 固定输入维度:避免动态分配张量导致内存碎片。

- 使用 DMA 缓冲采样:提升音频输入吞吐率。

- 简化后处理逻辑:仅输出最大置信度类别。

- 双核并行:主核推理、副核负责采样和通信。

这些工程优化能显著提高稳定性与实时性能,

使 ESP32-S3 在不依赖外部 AI 芯片的情况下稳定实现语音唤醒。

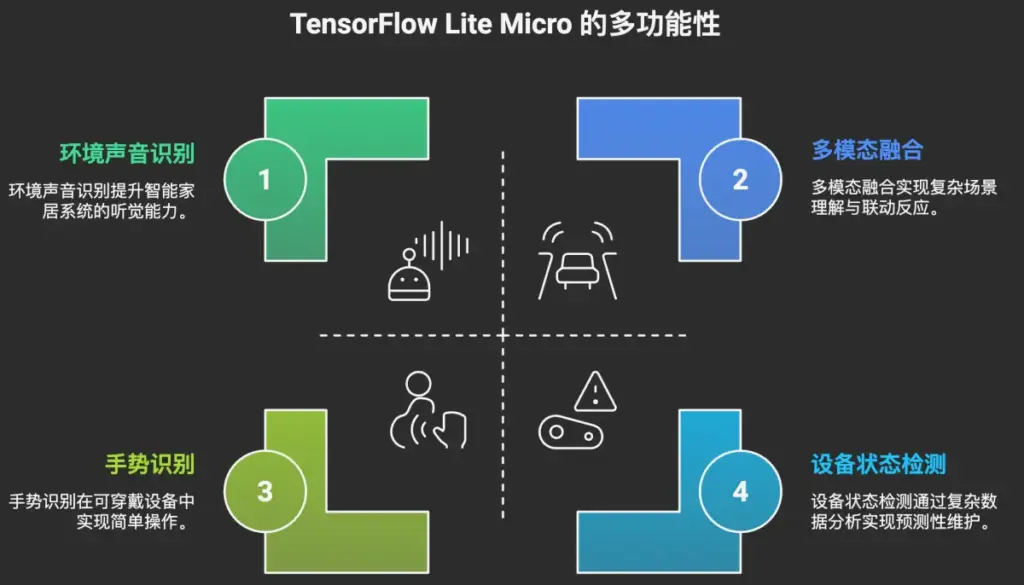

四、延展能力:TFLM 不止语音唤醒

语音唤醒只是 TensorFlow Lite Micro 的“入门级任务”。

真正的价值在于:同一硬件平台可以通过更换模型,具备更多类型的智能感知能力。

这意味着 ESP32-S3 + TFLM 不是一个语音识别方案,而是一套可编程的边缘智能框架。

1. 环境声音识别

在智能家居和安防场景中,环境声音识别能够显著提升系统的“听觉”能力:

- 识别玻璃破裂、门铃、烟雾报警声等事件;

- 判断是否有宠物活动、是否存在异常噪声;

- 实现“声学触发”的本地警报。

这类模型通常输入为 1 秒左右的音频 MFCC 序列,输出多个分类结果,

例如:["dog_bark", "alarm", "speech", "background"]。

ESP32-S3 的 NPU 向量指令在此类任务上表现稳定,可实现约 8–12 FPS 的实时处理速度。

2. 设备状态与机械振动检测

工业设备往往无法长时间联网,而机器运行声和振动数据却蕴含大量可用信息。

通过 TFLM 模型,ESP32-S3 可以对这些数据进行本地模式识别,

判断电机是否磨损、风机是否失衡、水泵是否空转。

优势在于:

- 实时性高:无需上传云端分析;

- 功耗低:持续监听功率小于 200mW;

- 安全性强:仅上报异常结果,避免隐私泄露或带宽浪费。

这类“边缘AI巡检”正在逐渐取代传统的远程传感方案,

让预测性维护在中小型设备中也具备可行性。

3. 手势与姿态识别

如果将音频输入换成 IMU(加速度计 + 陀螺仪),

TensorFlow Lite Micro 同样可以运行轻量级动作识别模型。

在可穿戴设备中,这意味着:

- 手势操作(抬腕亮屏、挥手控制);

- 姿态识别(行走、跑步、跌倒);

- 用户习惯建模(使用频率、运动节奏)。

ESP32-S3 的双核结构可分别处理传感器数据和推理任务,

保证在低延迟下完成实时动作判断。

4. 环境语义判断与多模态融合

TFLM 还支持多输入数据源的“轻融合”:

例如,将麦克风与光照、温湿度、红外等传感器数据组合,

判断环境状态是否“有人”、“嘈杂”或“安全”。

在智能家居或商业场景中,这类能力可用于:

- 根据环境噪声自动调整音量;

- 判断会议室是否空闲;

- 检测入侵或异常活动。

这一层能力意味着 ESP32-S3 不仅“能听”,

更开始具备对场景的“理解”与“联动反应”。

五、云端协同与系统演进

TensorFlow Lite Micro 的设计初衷之一,就是构建云端训练 + 设备推理的闭环。

1. 本地与云端的角色分工

| 功能环节 | 设备端(ESP32-S3) | 云端(TensorFlow / Server) |

|---|---|---|

| 数据采集 | 音频、传感器实时采样 | — |

| 特征提取 | MFCC / FFT 计算 | 数据清洗与增强 |

| 模型训练 | — | TensorFlow 训练优化 |

| 模型部署 | 通过 OTA 更新 .tflite 文件 | 模型管理与下发 |

| 推理执行 | TFLM 实时运行 | 接收事件结果、统计分析 |

2. OTA 模型更新机制

ESP32-S3 支持 OTA 升级,开发者可将模型文件作为独立分区下发。

这样,当环境噪声、口音或设备任务变化时,

只需在云端重新训练并更新模型,即可实现持续演进的本地智能。

这种方式在智能家居、可穿戴、工业传感节点中都非常有价值,

既保证了响应速度,又降低了云端依赖。

六、典型应用场景

| 场景 | 应用说明 |

|---|---|

| 智能家居 | 离线语音控制、环境声检测、智能安防响应 |

| 可穿戴设备 | 手势识别、跌倒检测、语音指令识别 |

| 工业监测 | 电机振动检测、异常声音报警、预测性维护 |

| 零售终端 | 声控广告屏、客流语音交互 |

| 农业与安防 | 动物活动检测、环境噪声监控、报警触发 |

这些应用共同特点是:

- 实时性强(无需云端确认)

- 低功耗运行(可持续监听)

- 数据私密(仅上传事件,不传原始音频)

七、对比与思考

| 对比维度 | 专用语音芯片 | ESP32-S3 + TensorFlow Lite Micro |

|---|---|---|

| 功能边界 | 固定唤醒词 / 语音命令 | 可自定义模型任务(语音、声音、姿态) |

| 灵活性 | 固件不可改 | 支持重新训练与模型替换 |

| 算法开放性 | 厂商封闭 SDK | 开源生态,自由扩展 |

| OTA 能力 | 不支持 | 支持模型热更新 |

| 应用范围 | 家电与遥控类语音控制 | 跨行业多模态感知(声音 / 动作 / 环境) |

这种转变代表着嵌入式AI的逻辑正在被重塑:

过去我们依赖专用芯片来“定义功能”;

现在我们用同一颗 MCU,通过模型去“定义能力”。

八、总结与启示

ESP32-S3 + TensorFlow Lite Micro 的组合,不仅实现了低功耗语音唤醒,

更打开了 MCU 级 AI 感知的边界。

它的意义可以概括为三层:

- 工程层面: 在有限算力与内存条件下,实现可量化、可部署的本地推理。

- 产品层面: 模型可替换、算法可更新,使硬件具备长期演进能力。

- 行业层面: 将边缘AI从高端SoC平台下沉到低功耗MCU设备, 让智能家居、可穿戴、工业监测等更多领域都能以更低成本获得AI能力。

语音唤醒只是开始。当每一颗 MCU 都能听、能学、能判断时,边缘智能将不再是“附加功能”,而是设备的基础能力。

典型应用介绍