- Mark Ren

-

-

-

1. 背景与问题定义:为什么 Opset 会成为 RKNN 项目的关键约束

1.1 从“模型能不能导出”到“模型能不能长期维护”

在很多边缘 AI 项目里,最初的关注点通常是:模型是否能从 PyTorch 正常导出 ONNX、是否能被工具链接受并在板子上跑起来。这个阶段的判断标准往往是“首个 Demo 是否成功”。

但一旦进入真实交付,问题会迅速发生变化:

- 模型需要小幅结构调整以适配新场景;

- 算法团队升级了基础框架或模型版本;

- 同一条产品线需要在多个 SoC 上复用模型。

这时,原本被视为“中间格式”的 ONNX opset,会突然变成一个高度敏感的工程约束。很多团队会在这个阶段才意识到:

模型能否持续演进,往往不是由精度或算力决定,而是由转换链路是否稳定决定。

这里的稳定性,并不是“今天能不能转”,而是在未来 6–12 个月内是否仍然可控。在 RKNN 场景下,opset 的选择几乎等价于对后续工程空间的提前锁定。

1.2 ONNX 的通用性,在 NPU 场景下为何会失效

从定位上看,ONNX 试图解决的是跨框架模型交换的问题,而不是为特定硬件提供执行保证。

这种设计在 CPU/GPU 生态中通常不是问题,因为:

- Runtime 可以通过 kernel fallback 覆盖未优化路径;

- 图优化和算子融合可以在运行时动态调整;

- 算子语义与执行方式之间存在较大的缓冲空间。

但在 NPU 场景中,这些前提大多不成立。NPU 的执行模型更接近 ASIC:

- 支持的算子集合有限且固定;

- 对张量形态、数据布局和算子组合有明确约束;

- 不存在“先跑起来再说”的运行时妥协空间。

结果就是:一个完全合法、甚至在 CPU 上验证通过的 ONNX 模型,依然可能在 NPU 转换阶段被直接拒绝。这并不是工具不成熟,而是硬件执行模型与通用中间表示之间的结构性差异。

1.3 RKNN 项目中 Opset 的真实含义

在 Rockchip 平台上,RKNN 工具链的角色并不是“解释并尽量执行 ONNX 图”,而是将 ONNX 图编译为 NPU 可执行的静态表示。

以 Rockchip 的 NPU 为例,转换阶段需要一次性完成以下判断:

- 每一个算子是否存在硬件映射;

- 算子属性是否满足 NPU 的形态约束;

- 整个计算图是否可以被完整下沉到 NPU。

在这个语境下,opset 不再只是语法版本,而是决定图结构表达方式的上游约束。不同 opset 下,同一算子可能在属性定义、默认行为或 shape 推导规则上存在差异,这些差异会被 RKNN 在编译阶段放大。

因此,opset 的选择并不是一个可以随意回滚的参数,更像是一次平台层面的技术决策:一旦确定,后续模型结构的自由度就已经被隐含限定。

2. RKNN / ONNX 转换机制:真正起作用的不是流程,而是约束点

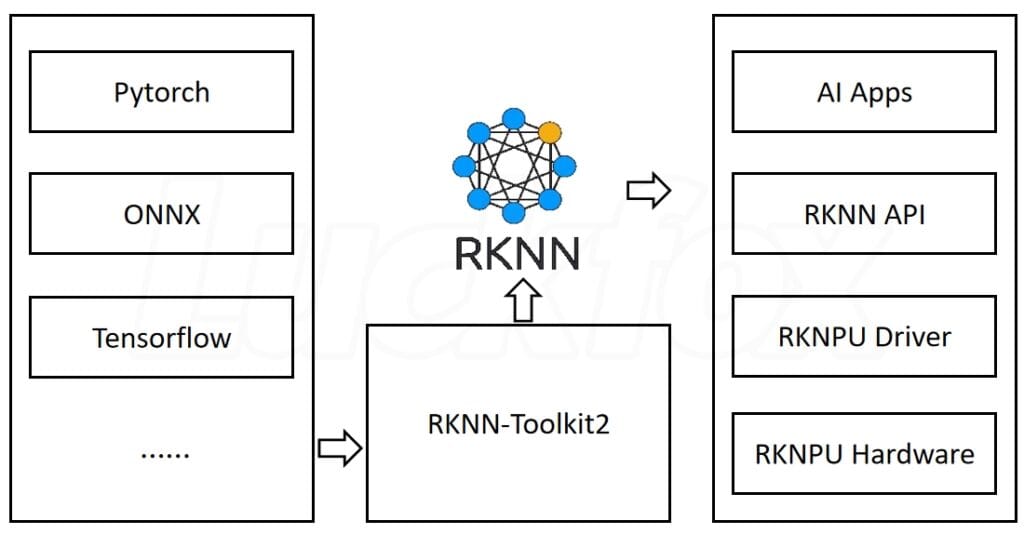

2.1 从 PyTorch 到 NPU 的实际转换链路

从表面上看,RKNN 的典型路径非常清晰:

PyTorch → ONNX(指定 opset)→ RKNN Toolkit → NPU Binary

但在工程实践中,真正决定成败的并不是这个线性流程,而是每一跳中哪些信息被保留、哪些被丢弃。

其中最脆弱、也最不可逆的一步,正是 ONNX → RKNN。

一旦进入 RKNN 转换阶段,模型不再被视为“可动态解释的计算图”,而是必须被完整编译的静态结构。任何无法映射到 NPU 的节点,都会导致整个转换失败,而不是局部退化。

2.2 RKNN 更像编译器,而不是推理 Runtime

与 GPU 生态中常见的推理引擎不同,RKNN 的工作方式更接近传统编译器:

- 所有算子映射在编译期完成;

- 不存在运行时动态分支或算子替换;

- 转换失败意味着设计假设本身不成立。

这也是为什么很多工程师在初次接触 RKNN 时,会对其“严格程度”感到不适应。

在 GPU 场景中形成的经验——“某个算子不支持,大不了慢一点”——在 NPU 上并不成立。

这种严格性并非缺陷,而是确定性换取效率的必然代价。一旦模型成功转换,其执行路径、延迟和资源占用都会变得高度可预测。

2.3 Opset 变化为何会直接影响转换稳定性

在 ONNX 生态中,opset 的演进往往意味着更灵活的表达能力:

- 更通用的算子定义;

- 更丰富的属性组合;

- 对动态 shape 更友好的语义。

但这些“改进”,在 RKNN 场景下往往会转化为新的不确定性。较新的 opset 可能引入 RKNN 尚未支持的属性,或者改变算子的默认行为,从而导致:

- 转换阶段直接报 unsupported attribute;

- 图结构通过检查,但在推理阶段表现异常;

- 同一模型在不同 opset 下表现出完全不同的稳定性。

这也是为什么在实际项目中,opset 往往不是越新越好,而是越“被验证过”越安全。

稳定性来自于约束的明确,而不是能力的最大化。

小结

在 RKNN 项目中,ONNX opset 并不是一个中性的中间选项,而是提前固化模型表达方式的工程决策。理解这一点,才能解释为什么很多问题并不是“模型不对”,而是“模型与硬件的契约不成立”。

3. 工程实现中的典型失败模式(ONNX → RKNN)

这一部分不再讨论“流程正确性”,而是聚焦工程师在真实项目中反复踩到的失败形态。

这些问题往往并不是文档缺失,而是工具链设计假设与模型设计假设不一致。

3.1 转换阶段失败 vs 推理阶段异常

在 RKNN 项目中,失败通常分为两类,这两类问题的工程代价完全不同。

表 3-1:两类失败模式的工程差异

| 维度 | 转换阶段失败 | 推理阶段异常 |

|---|---|---|

| 发生时间 | ONNX → RKNN 转换期 | NPU 推理运行期 |

| 常见表现 | unsupported op / attribute | 输出异常、精度塌陷 |

| 定位难度 | 相对明确 | 极高 |

| 是否可规避 | 可,通过结构约束 | 很难,通常需重构 |

| 工程风险 | 前置暴露 | 后置爆雷 |

工程实践中,更危险的并不是“转不了”,而是转得了但结果不可信。

前者会阻断流程,但后者往往在系统联调或量产测试阶段才被发现,修复成本显著更高。

3.2 常见不兼容算子与结构特征

在多数失败案例中,问题并不集中在“冷门算子”,而是集中在模型结构的表达方式上。

高频风险结构(非算子清单)

- 动态 shape 推导

- 多次 reshape / permute 叠加

- 检测头中内嵌 post-process 逻辑

- 隐式 broadcast 行为

这些结构在 ONNX 层面完全合法,但在 NPU 编译阶段会暴露出以下问题:

- shape 在编译期不可确定

- 数据布局无法映射到固定硬件路径

- 算子组合超出 NPU 的融合能力

ONNX 合法但 NPU 不可执行的典型路径

--- title: "ONNX 合法结构 vs NPU 可执行结构差异" --- graph TD; A["ONNX GraphDynamic Shape"] --> B["合法语义通过 Checker"]; B --> C["RKNN 编译期 Shape 固化"]; C -->|无法确定| D["转换失败"];

这里的关键不在于 ONNX “错了”,而在于 NPU 需要的是一个完全确定的执行图。

3.3 Opset 与模型结构的“组合风险”

一个常被低估的事实是:

opset 单独看没问题,模型结构单独看也没问题,但组合在一起就会失败。

这是因为 opset 的变化,往往会改变算子默认行为或属性表达方式,而这些变化会直接影响 RKNN 的编译判断。

表 3-2:opset × 结构组合的典型风险

| 组合特征 | 表面状态 | 实际风险 |

|---|---|---|

| 新 opset + 动态 shape | ONNX 合法 | 编译期不可确定 |

| 新 opset + 检测头复杂化 | 可导出 | NPU 映射失败 |

| 旧 opset + 简化结构 | 看似保守 | 稳定性最高 |

这也是为什么很多团队在回溯问题时会发现:

回退 opset 并没有“降级能力”,反而恢复了可控性。

4. YOLOv8 在 RKNN 场景下的特殊性

YOLOv8 并不是“不适合 RKNN”,但它的设计目标与 NPU 的执行模型之间,确实存在天然张力。

4.1 YOLOv8 的结构特征

YOLOv8 系列在工程上有几个显著特征:

- Head 结构高度模块化

- 广泛使用 reshape / concat / split

- 对动态尺寸输入支持友好

- 后处理逻辑趋向模型内聚

这些特征在 GPU / CPU 场景下是优势,但在 NPU 上,会显著增加编译期复杂度。

4.2 YOLOv8 → RKNN 的常见断点

Mermaid:YOLOv8 到 RKNN 的关键断点示意

--- title: "ONNX 合法结构 vs NPU 可执行结构差异" --- graph LR %% ===== Styles ===== classDef onnx fill:#E3F2FD,stroke:#1976D2,stroke-width:2,rx:10,ry:10,color:#0D47A1,font-weight:bold; classDef ok fill:#E8F5E9,stroke:#2E7D32,stroke-width:2,rx:10,ry:10,color:#1B5E20,font-weight:bold; classDef npu fill:#FFF8E1,stroke:#F9A825,stroke-width:2,rx:10,ry:10,color:#5D4037,font-weight:bold; classDef fail fill:#FFEBEE,stroke:#C62828,stroke-width:2,rx:10,ry:10,color:#B71C1C,font-weight:bold; classDef note fill:#FFF9E6,stroke:#E6A700,stroke-width:1.5,rx:8,ry:8,color:#5D3B00; linkStyle default stroke:#555,stroke-width:1.6; %% ===== Paths ===== A["ONNX GraphDynamic Shape / Dynamic Ops"]:::onnx B["ONNX Checker / Runtime语义合法(可推理)"]:::ok C["NPU 编译器(RKNN)编译期 Shape 固化"]:::npu D["无法确定维度(H/W/Batch/Anchors)"]:::fail E["转换失败 / 回退 CPU性能不可控"]:::fail %% ===== Flow ===== A -->|"结构与语义正确"| B B -->|"进入 NPU 编译链路"| C C -->|"需要静态 shape"| D --> E %% ===== Hint ===== N1["解决方向:导出 ONNX 时固定输入尺寸;消除动态维度与动态控制流;将 NMS 等后处理移出 NPU。"]:::note E -.-> N1

这些断点并不是偶发 bug,而是模型设计目标与硬件执行模型不一致的直接体现。

4.3 YOLOv8 各任务类型的风险差异

表 4-1:YOLOv8 任务类型与 RKNN 适配风险

| 任务类型 | 转换风险 | 工程说明 |

|---|---|---|

| Detection | 中 | 需控制 head 复杂度 |

| Segmentation | 高 | mask 分支结构复杂 |

| Pose | 很高 | keypoint 维度动态性强 |

从工程角度看,这并不是 YOLOv8 “不好”,而是它并非以 NPU 编译为第一设计目标。

小结

当 RKNN 转换失败反复出现时,问题通常不在某一个算子,而在模型表达方式与 NPU 执行模型之间的系统性不匹配。

在这一层面上,opset、模型结构与任务类型是一个不可拆分的整体。

4. 工程取舍与系统适配:模型自由度与 NPU 确定性怎么换算

前两部分把“为什么会失败、在哪里失败”讲清楚后,剩下的问题就很直接:到底要不要继续把模型往 RKNN 这条链路里塞,还是应该调整目标,把 NPU 当作一个受约束的执行单元来设计系统。

4.1 两种路线的本质差异:你是在优化模型,还是在优化交付

很多团队在讨论“RKNN 适配”时,表面是在讨论算子支持,实际是在讨论交付形态:

- 如果产品要求频繁迭代模型结构(尤其是检测头、后处理、输入尺寸策略),那么你需要的是“演进空间”

- 如果产品要求确定的延迟、功耗与成本,并且模型结构相对稳定,那么你需要的是“确定性”

这两者很难同时最大化。RKNN 的价值通常不在于让你拥有更自由的模型,而在于让系统在性能和成本上更可预测。

表 4-1:两条路线的工程取舍(偏决策视角)

| 关注点 | “通用 ONNX / GPU 或 CPU 友好”路线 | “RKNN / NPU 友好”路线 |

|---|---|---|

| 模型结构迭代 | 自由度高,代价更多在算力 | 受约束,代价更多在设计阶段 |

| 性能可预测性 | 受运行时影响,波动更大 | 更稳定,容易做容量规划 |

| Debug 体验 | 工具多、可视化强 | 更依赖工具链输出与约束经验 |

| 量产一致性 | 受驱动/版本影响 | 转换成功后稳定性更强 |

| 组织协作成本 | 算法侧主导 | 需要算法与工程共同约束 |

读到这里通常会出现一个“看似反直觉但很真实”的结论:在 RKNN 项目里,最省成本的做法往往不是在报错后逐个修补,而是在模型设计阶段就把“硬件可执行”当作第一约束。

4.2 Opset 锁定对产品生命周期的影响

opset 在 RKNN 项目里更像“接口契约版本”。一旦选定并跑通,后续每一次升级都要像升级系统依赖一样谨慎对待。

常见的生命周期节奏通常是:

- PoC 阶段:能跑起来最重要,opset 先选一个可用范围

- MVP 阶段:开始锁定 op/shape 约束,优先做稳定性

- 量产阶段:尽量冻结 op、opset、工具链版本与导出脚本,减少漂移

- 迭代阶段:把“可演进的部分”放到系统层,而不是持续挑战 NPU 约束边界

把“可变”放到系统层的典型方式

--- title: "将模型变化从 NPU 约束中剥离的系统分层" --- graph TD %% ===== Styles ===== classDef input fill:#E3F2FD,stroke:#1976D2,stroke-width:2,rx:10,ry:10,color:#0D47A1,font-weight:bold; classDef npu fill:#E8F5E9,stroke:#2E7D32,stroke-width:2,rx:10,ry:10,color:#1B5E20,font-weight:bold; classDef post fill:#FFF8E1,stroke:#F9A825,stroke-width:2,rx:10,ry:10,color:#5D4037,font-weight:bold; classDef biz fill:#F3E5F5,stroke:#8E24AA,stroke-width:2,rx:10,ry:10,color:#4A148C,font-weight:bold; classDef note fill:#FFF9E6,stroke:#E6A700,stroke-width:1.5,rx:8,ry:8,color:#5D3B00; linkStyle default stroke:#555,stroke-width:1.6; %% ===== Layers ===== A["📥 输入策略层Resize · Crop · Tiling · Padding"]:::input B["⚡ NPU 固化模型RKNN Stable Graph(Static Shape / INT8)"]:::npu C["🧩 输出后处理层Decode · NMS · CPU / 轻量 DSP"]:::post D["🧠 业务策略层阈值 · 规则 · 联动 · 告警"]:::biz %% ===== Flow ===== A -->|"标准化输入"| B B -->|"Raw Tensor Output"| C C -->|"结构化结果"| D %% ===== Key Insight ===== N1["设计原则:1️⃣ 所有“变化”留在 NPU 外部2️⃣ NPU 只运行稳定、可预测的计算图3️⃣ 解码 / NMS / 业务规则永远不进 NPU"]:::note B -.-> N1

如果你的产品需要“经常改”,更合理的方式往往是把变化集中在输入策略、后处理与策略层,把 NPU 模型当作一个稳定的高吞吐算子块来用。

4.3 System Fit:哪些系统适合 RKNN,哪些系统不适合

这一步不需要口号,只需要把系统类型分清楚。

表 4-2:系统类型与 RKNN 适配程度

| 系统类型 | 适配程度 | 原因 |

|---|---|---|

| 单任务、结构稳定的检测/分类 | 高 | 模型冻结后收益明显,性能确定性强 |

| 多模型频繁 AB 实验(算法驱动) | 低 | 工具链和约束会成为迭代节奏瓶颈 |

| 需要动态输入尺寸/动态 batch | 低 | 编译期固化困难,风险集中在形状推导 |

| 端侧强功耗/成本约束(量产) | 高 | NPU 的优势更容易兑现 |

| 复杂后处理强依赖图内表达 | 中到低 | 需要拆分后处理,或重构 head |

这里有一个很实用的判断方式:如果你的迭代主要来自“阈值/规则/流程”,RKNN 更友好;如果你的迭代主要来自“模型结构/算子/导出脚本”,RKNN 会越来越像一条需要专人维护的生产线。

5. 使用边界与设计建议:什么时候该停,怎么把风险前置

这一章不讲“最佳实践清单”,只回答工程里最常见的两个问题:什么时候不该继续硬适配,以及如何在早期把失败成本压到最低。

5.1 什么时候不应该继续“硬上 RKNN”

以下信号出现 2–3 个,通常就意味着继续适配的收益开始下降:

- 模型每次小改都会引入新的不兼容节点,且无法通过局部替换解决

- 你发现自己在为工具链写越来越多“导出特化脚本”,并且团队里只有少数人能维护

- 转换虽然成功,但推理异常无法稳定复现或无法解释(最危险)

- 产品路线要求频繁更换 backbone/head 或引入新的任务分支(例如从 det 扩展到 seg/pose)

- 版本升级变成“赌运气”,缺少一套可重复的验证基线

这类情况下更务实的做法通常是二选一:要么把模型结构收敛到 NPU 友好形态,要么把 NPU 的边界缩小,只承担它擅长的那部分。

5.2 面向 RKNN 的模型设计原则

这些原则的价值不在“写得漂亮”,而在“能减少组织摩擦”,让算法团队和工程团队对同一件事有共同语言。

- 优先选择可静态确定的 shape 路径,避免把动态性带进 NPU 编译阶段

- 尽量减少多次 permute/reshape 的叠加,尤其是在 head 附近

- 后处理优先放在模型外(CPU/轻量算子),把 NPU 输出当作“原始预测张量”

- 对 opset、导出脚本、工具链版本建立可追溯基线,避免“同名模型不同图”

- 把“可被 NPU 编译”当作验收条件,而不是把“报错修掉”当作验收条件

这些话听起来克制,但它们往往决定了你在量产阶段到底是“复用流水线”,还是“每周救火”。

5.3 一套可落地的早期验证方法(把试错前移)

在项目早期,最有效的不是追求一次性把精度做到极致,而是先建立一个“稳定可重复”的验证闭环:

- 固定导出入口:同一 PyTorch commit + 同一导出脚本 + 同一 opset

- 固定对照输入:准备少量可重复的样本张量,避免数据扰动影响判断

- 固定转换输出:记录 RKNN 转换日志、图优化摘要、量化配置与最终产物 hash

- 固定端侧校验:至少包含输出张量统计(min/max/均值/分布),不要只看肉眼效果

- 固定回归门槛:每次模型改动必须先过“可编译 + 输出一致性”再谈精度提升

当这套基线建立起来,opset 的选择就不再是“凭经验猜”,而是“用事实锁定”。

6. 常见报错 → 结构原因 → 处理策略(ONNX → RKNN 工程对照表)

说明:不同 RKNN Toolkit / rknn-toolkit2 版本、不同 SoC 以及 ONNX 导出链路会导致报错文本略有差异。表中按“你看到的典型关键词”归类,便于快速定位根因与处理方向。

表 6-1:转换期高频报错对照

| 常见报错关键词(或近似文本) | 更可能的结构原因(优先排查顺序) | 工程处理策略(按成本从低到高) |

|---|---|---|

Unsupported operator: <OpName> / op not support | 1) 模型包含 NPU 不支持算子 2) 算子虽支持但输入 rank/属性组合超出支持范围 | 1) 在导出前替换等价结构(例如用可支持的组合替代) 2) 将该子图拆到 CPU 侧执行(如果链路允许) 3) 重构网络结构(尤其 head/后处理部分) |

Attribute <xxx> not supported / invalid attribute | 1) opset 升级导致属性表达变化 2) 导出时生成了 RKNN 未覆盖的 attribute 组合 | 1) 回退 opset 到已验证范围 2) 调整导出参数,避免生成该 attribute 3) 改写对应层结构(避免触发该属性分支) |

Cannot infer shape / shape inference failed / unknown dimension | 1) 动态 shape 进入关键路径 2) 多次 reshape/concat/split 叠加导致 shape 推导断裂 | 1) 固定输入尺寸与 batch=1(先跑通) 2) 在导出前显式固化 shape(避免 -1 传播) 3) 简化 head 的 reshape/concat 链 |

Concat axis mismatch / dimension mismatch | 1) Concat 前各分支维度不一致(多来自 resize/stride 对齐问题) 2) 导出后某分支被优化导致维度漂移 | 1) 检查各分支 feature map 尺寸与对齐策略 2) 禁用部分图优化(若工具提供) 3) 重构特征融合方式(减少跨尺度 concat) |

Reshape failed / invalid reshape | 1) reshape 使用了依赖动态维度的目标 shape 2) 上游维度被量化/融合改变 | 1) 将 reshape 目标改为静态常量 2) 把 reshape 移到模型外(后处理) 3) 通过替代结构减少 reshape 链 |

Transpose/Permute not supported / layout not supported | 1) 频繁 NCHW↔NHWC 或跨维度转置 2) transpose 发生在 head/输出附近导致 NPU 无法融合 | 1) 减少 permute 次数(提前统一布局) 2) 把布局变换放到输入预处理或输出后处理 3) 重新设计 head 以避免跨布局操作 |

Gather/Scatter not supported / indices 관련错误 | 1) 使用了索引类算子(常见于 pose/seg 或复杂后处理) | 1) 将索引逻辑移到 CPU 后处理 2) 将相关分支从模型中剥离 3) 选择更 NPU 友好的任务头结构 |

NonMaxSuppression / NMS 不支持或报错 | 1) 把 NMS 内嵌进模型图 2) NMS 参数/输入形态不符合转换约束 | 1) 将 NMS 移到模型外(强建议) 2) 输出 raw boxes/scores 由 CPU 做 NMS 3) 若必须端侧加速,考虑专用实现路径(但要接受平台绑定) |

TopK / Sort / ArgMax 不支持或异常 | 1) 排序/选取类算子进入图内后处理 2) 与动态 shape 叠加更容易触发失败 | 1) 后处理外置 2) 用阈值过滤+简单选择替代复杂排序 3) 重新规划输出格式减少 TopK 依赖 |

Reduce*(ReduceSum/Mean/Max)异常或不支持某 axis | 1) reduce 的 axis 组合超出支持范围 2) keepdims 等属性组合不被覆盖 | 1) 调整 reduce 维度与 keepdims 组合 2) 通过 reshape 将 reduce 转为可支持形态 3) 替换为等价卷积/池化结构(视任务而定) |

Pad mode not supported / pads 错误 | 1) 使用了反射/对称 pad 或复杂 padding 2) padding 发生在关键融合路径 | 1) 改为 constant pad 2) 将 padding 合并进卷积参数(若可能) 3) 重构网络避免特殊 pad |

Resize / Upsample 不支持某 mode(linear/cubic) | 1) 上采样模式不被支持 2) align_corners 等参数组合不兼容 | 1) 改用 nearest(通常最稳) 2) 将 resize 外置到预处理/后处理 3) 用反卷积或可支持的上采样结构替代 |

Quantization failed / calibration 相关错误 | 1) 校准数据不匹配输入预处理 2) 某些算子量化路径不稳定 3) 分支输出范围异常 | 1) 先 FP 跑通再量化 2) 校准集对齐真实输入分布 3) 对敏感层做保留 FP / 混合精度(若支持) |

Accuracy drop / 输出偏差很大但不报错 | 1) 量化引入误差(尤其检测头/激活) 2) 某些算子数值实现差异(NPU vs reference) | 1) 建立层级对齐(对比中间 tensor) 2) 调整量化策略与校准集 3) 重新设计 head 或把敏感后处理外置 |

结语

RKNN / ONNX opset 的兼容性问题,看起来像工具链问题,实际是一个工程契约问题:你在模型里表达的自由度越高,NPU 这类静态编译后端就越难承诺可执行;而一旦你接受约束并把变化放到系统层,NPU 的确定性优势才会真正兑现。

典型应用介绍